KunAvatar

综合介绍

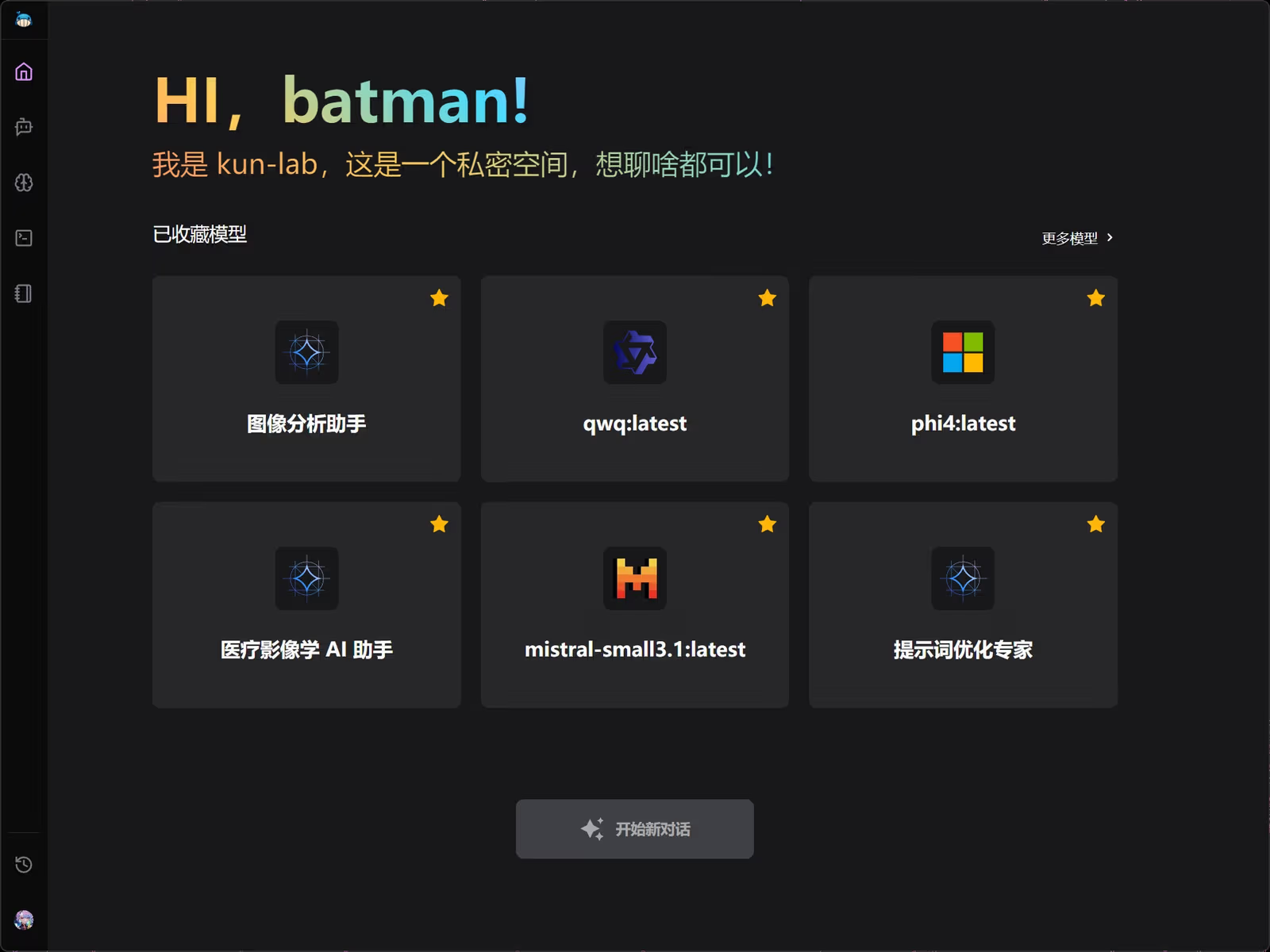

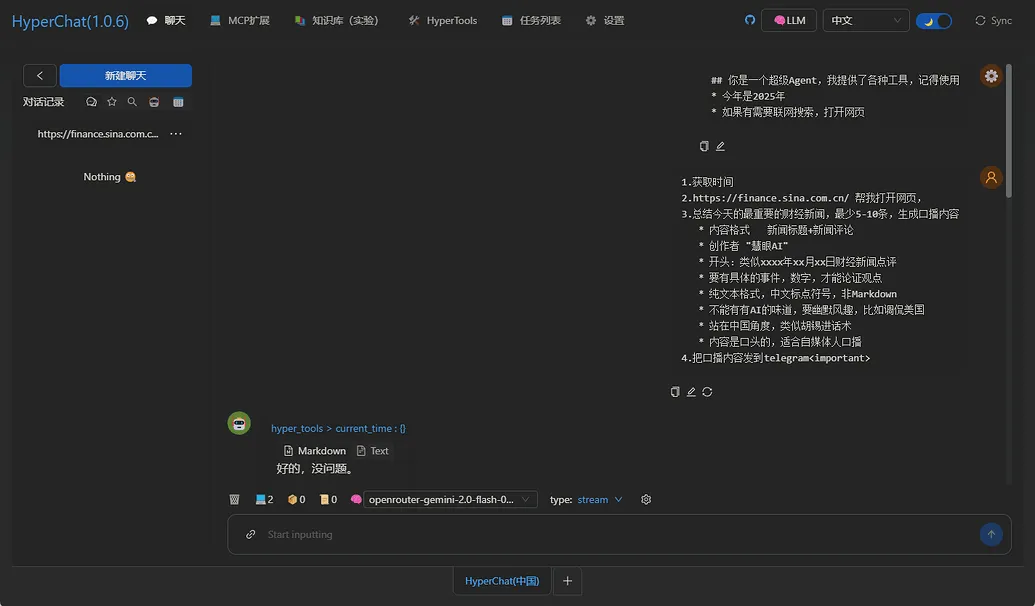

KunAvatar(原名kun-lab)是一个轻量级的AI应用,它被设计在用户自己的电脑或服务器上本地部署。这个应用的核心是提供一个完整的AI对话解决方案,但它最大的特点是拥有独特的“记忆系统”和“MCP工具调用”功能。记忆系统让AI能够记住之前的对话内容,使得交流更加连贯和深入。工具调用则允许AI连接并使用外部的程序或服务,极大地扩展了它的能力范围,不再局限于单纯的聊天。此外,KunAvatar还内置了企业级的用户管理体系,支持多个用户和权限分配。因为所有数据都保存在本地,用户的隐私和信息安全得到了充分的保障。

功能列表

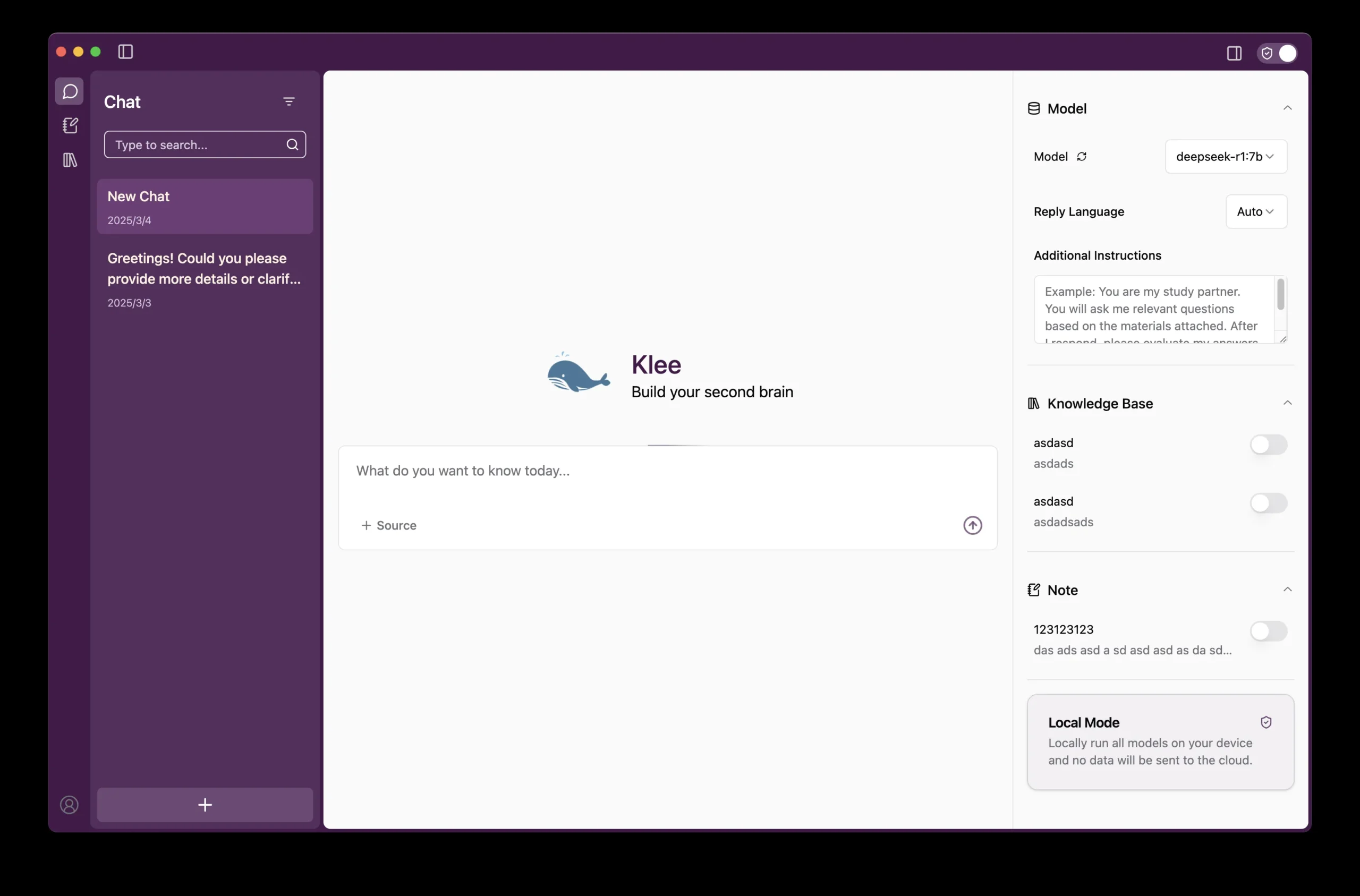

- 高级记忆系统:拥有递归式记忆功能,AI可以智能地分析、提取和更新对话中的关键信息,实现真正的长期记忆,而不是简单地重复上下文。

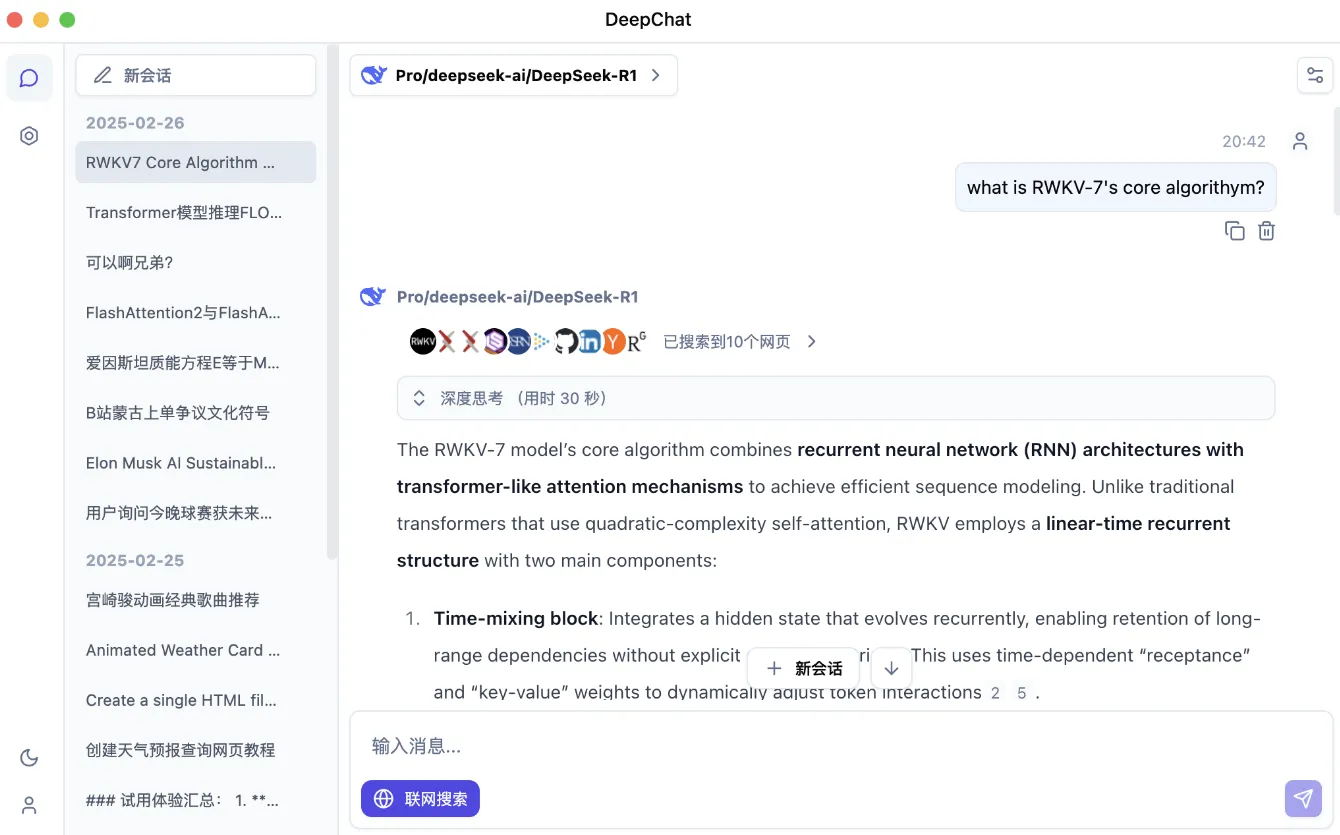

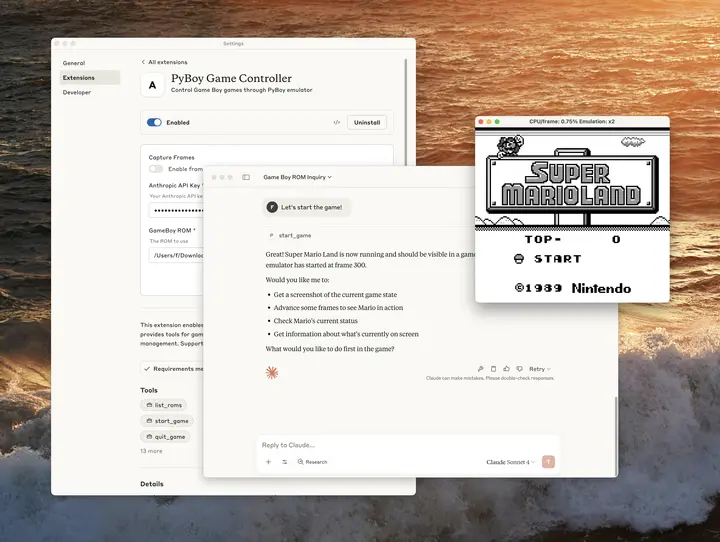

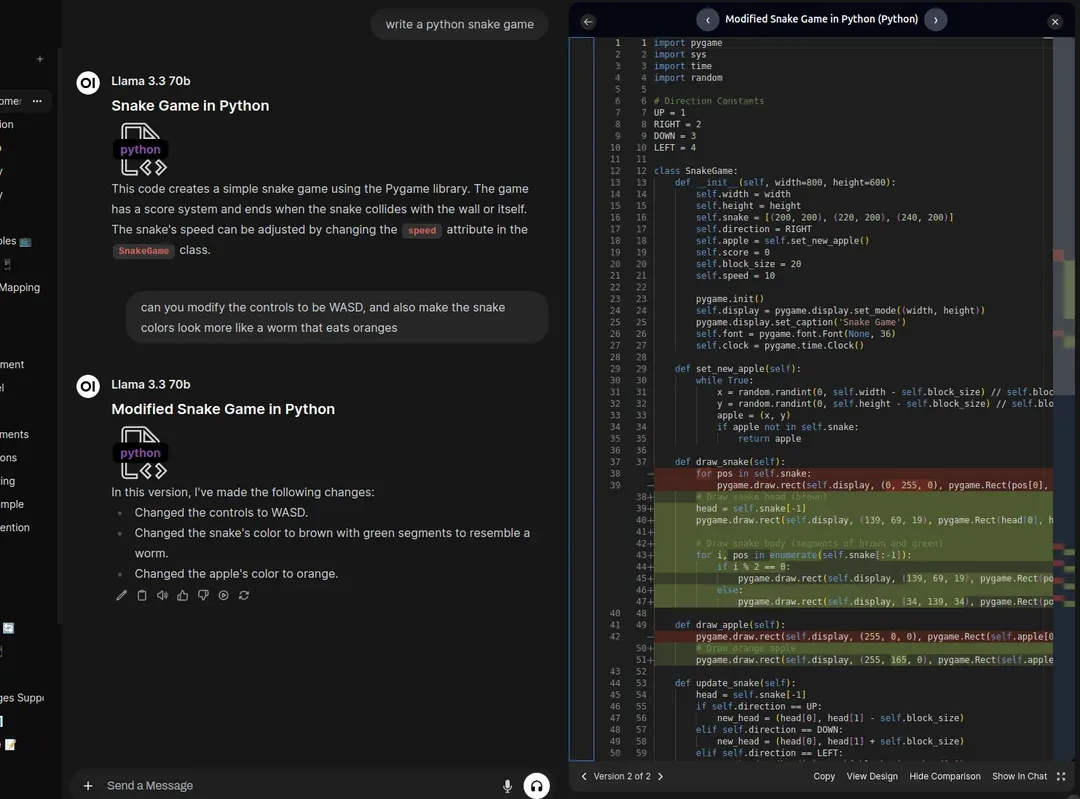

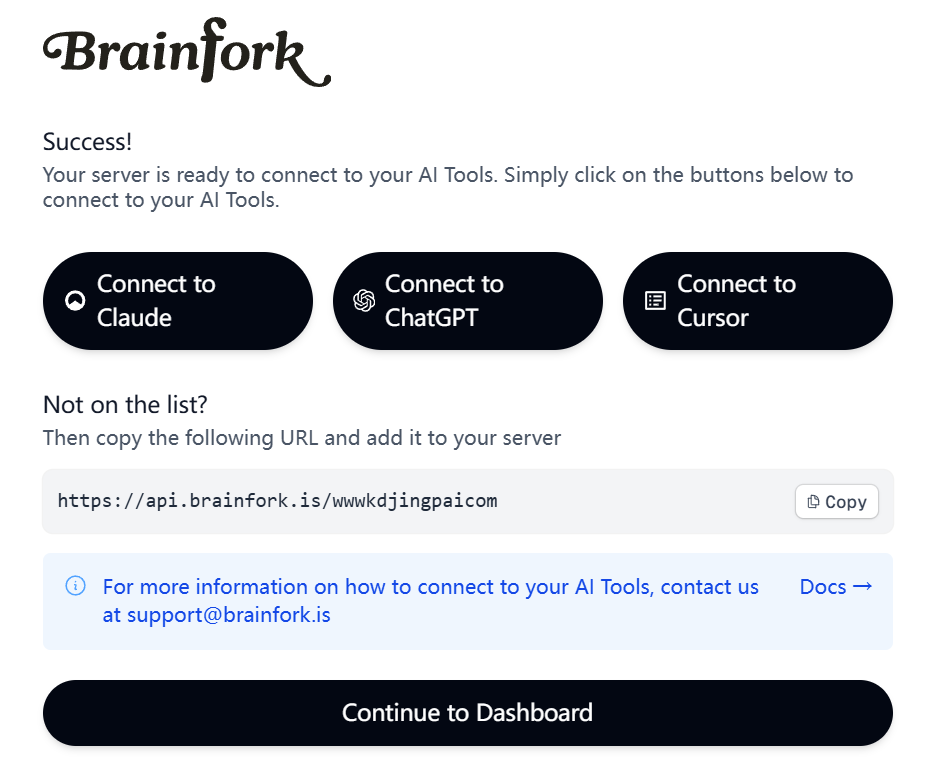

- MCP工具集成:支持通过多种协议(如SSE、Streamable HTTP)连接外部工具和服务。AI可以直接调用这些工具来完成搜索、计算或与其他系统交互等复杂任务。

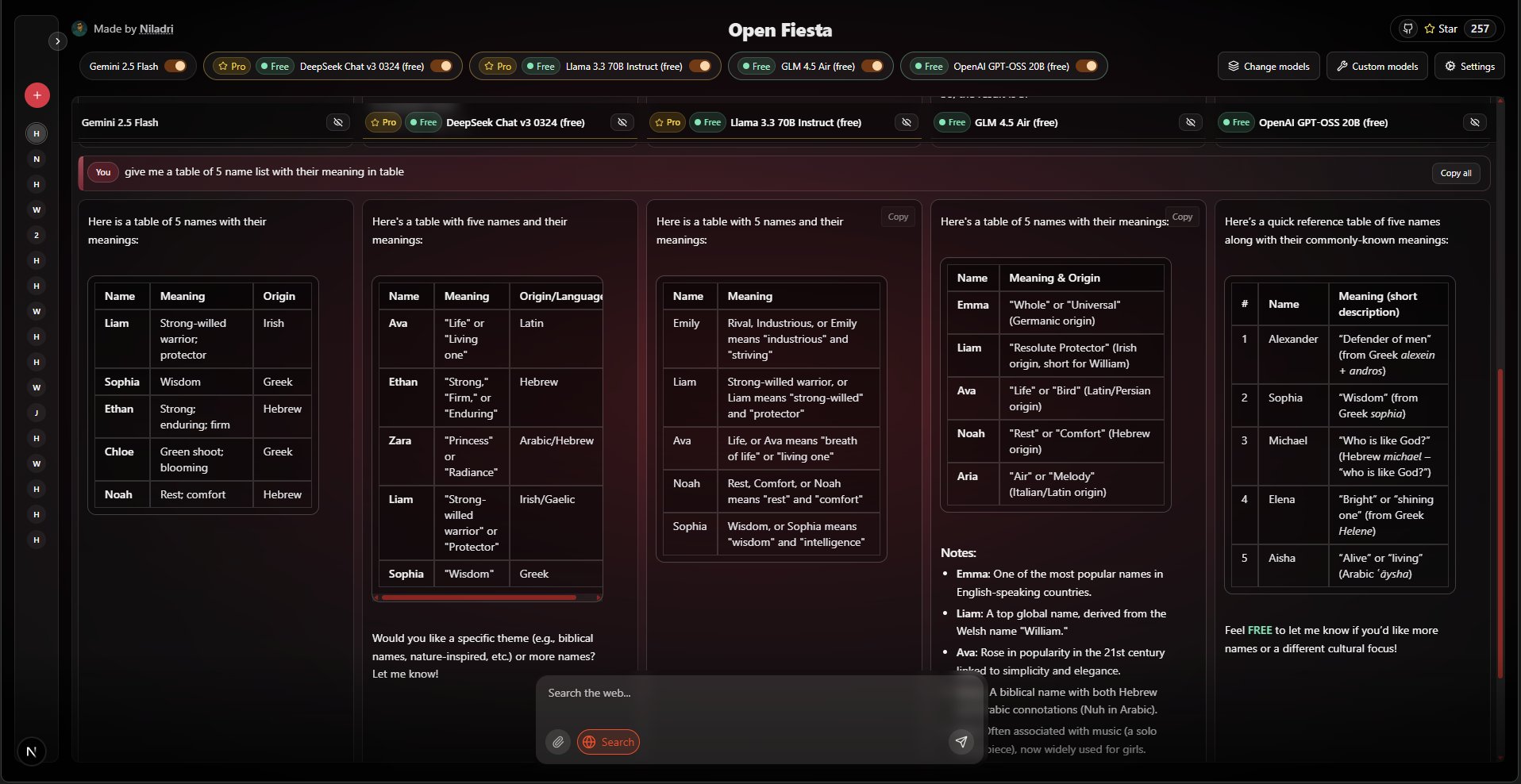

- 辅助模型协作:系统可以同时运行多个AI模型。一个主模型负责与用户对话,而其他辅助模型则在后台进行提示词优化、生成对话摘要等工作,分工协作以提升整体效率和体验。

- 可配置智能体:用户可以创建不同用途的“智能体”(Agent),为每个智能体配置专属的系统提示词、AI模型和可调用的工具集,打造面向特定领域的专业AI助手。

- 企业级用户管理:内置基于角色(RBAC)的权限控制系统,支持多用户和多租户管理。管理员可以精细地控制每个用户的权限和数据访问范围,确保数据安全隔离。

- 本地化部署:所有程序和数据都运行和存储在用户的本地设备上,支持局ax域网访问,从根本上保证了数据隐私和安全。

- 现代化的对话界面:提供流畅的流式对话响应,AI的回答会逐字显示。同时支持完整的对话历史记录、搜索和管理功能。

使用帮助

KunAvatar的设计目标是让用户能够在自己的设备上,轻松地搭建一个功能强大的私有AI环境。以下是详细的安装和使用流程,旨在帮助您快速上手。

第一步:环境准备

在安装KunAvatar之前,请确保您的系统满足以下基本要求。这些是运行程序所必需的软件环境。

- Node.js: 版本需要

22.15.0或更高。Node.js是运行KunAvatar后端和前端环境的基础。 - npm: 版本需要

11.3.0或更高。npm是Node.js的包管理器,用于安装项目所需的各种依赖库。 - Ollama: 版本建议

0.9.6或更高。Ollama是一个关键组件,它是在您本地运行大语言模型的服务。KunAvatar通过Ollama来驱动AI对话。

第二步:安装Ollama和AI模型

Ollama是整个系统的AI大脑。您需要先安装它,并下载至少一个AI模型。

- 访问 Ollama官网,根据您的操作系统(Windows, macOS, Linux)下载并安装Ollama程序。

- 安装完成后,打开您电脑的终端或命令行工具。

- 输入以下命令来下载一个基础AI模型,例如Google的

gemma2模型。拉取过程会需要一些时间,具体取决于您的网络速度。ollama pull gemma2您可以从Ollama官网的模型库中找到更多不同大小和用途的模型,并使用相同的命令进行下载。

第三步:安装和启动KunAvatar应用

当AI模型准备好后,就可以安装和启动KunAvatar主程序了。

- 克隆项目代码:打开终端,使用

git命令将项目的源代码从GitHub克隆到您的本地电脑。git clone https://github.com/KunLabAI/KunAvatar.git - 进入项目目录:

cd KunAvatar - 安装依赖:在项目根目录下,运行官方提供的一键安装脚本。这个脚本会自动安装前端和后端所需的所有依赖包。

npm run install - 构建项目:安装完依赖后,需要对项目进行构建,将其编译成可运行的版本。

npm run build - 启动应用:构建完成后,使用以下命令启动应用。

npm start此命令会启动一个智能脚本,它将自动检测您电脑的IP地址,配置局域网访问,并启动服务。启动成功后,它会自动在您的默认浏览器中打开应用界面。

第四步:首次配置 - 创建管理员账户

第一次运行KunAvatar时,系统里没有任何用户。您需要创建一个管理员账户来管理整个应用。

- 重新打开一个新的终端窗口。

- 进入项目目录下的

scripts文件夹:cd kunavatar/scripts - 运行初始化管理员脚本:

node init-admin.js - 按照命令行的提示,输入您想要设置的管理员用户名和密码。创建成功后,您就可以使用这个账户登录系统了。

第五步:日常使用

登录后,您就可以开始探索KunAvatar的各项功能了。

- 开始对话:在主界面,您可以从右上角选择一个已经通过Ollama下载的AI模型,然后就可以在下方的输入框中开始对话了。

- 配置智能体:在左侧菜单栏可以进入“智能体”管理界面。在这里,您可以创建新的智能体,为它设定一个特定的角色(例如“编程助手”),并为这个角色配置专用的系统提示词和可使用的工具。

- 连接外部工具(MCP):在“MCP配置”中,您可以添加外部工具服务器的地址。连接成功后,您创建的智能体就可以在对话中调用这些工具来完成更复杂的任务。

应用场景

- 个人本地AI助手用户可以在个人电脑上部署KunAvatar,将其作为一个完全私密、无需联网的AI助手。利用其记忆系统,AI可以持续学习用户的偏好和常用信息,成为一个真正懂你的个人知识助理,可用于日常写作、编程辅助和信息整理。

- 团队知识库与协作平台在团队的局域网服务器上部署KunAvatar,可以作为团队的共享智能大脑。通过配置不同的智能体和用户权限,团队成员可以在一个安全的环境内进行头脑风暴、查询内部资料或协同完成任务,所有交流和数据都保留在团队内部。

- 企业级智能工具集成对于企业来说,KunAvatar的企业级用户管理和MCP工具调用功能非常有价值。企业可以将其作为内部系统的统一智能入口,通过MCP协议连接到企业已有的API(如订单查询、库存管理等),让员工通过自然语言对话来操作复杂的内部系统,提升工作效率。

- AI开发者与爱好者的实验平台开发者可以利用KunAvatar作为测试和验证新想法的平台。通过其灵活的工具集成能力,开发者可以快速将自己开发的工具连接到AI模型上,探索Agent智能体的应用潜力。研究人员也可以在一个稳定、可控的本地环境中,对不同模型的行为和记忆机制进行实验。

QA

- KunAvatar和kun-chat有什么关系?KunAvatar是kun-chat项目的正式继承者和升级版本。官方已声明kun-chat不再更新,并推荐所有用户迁移到KunAvatar。KunAvatar在kun-chat的基础上,增加了如高级记忆系统、MCP工具调用、模型协作和企业级用户管理等核心功能。

- 使用KunAvatar需要付费吗?不需要。KunAvatar项目基于Apache 2.0开源许可证,这意味着您可以免费地使用、修改和分发该软件。您只需要遵守许可证的相关条款即可。

- 我的对话数据是否安全?是的,非常安全。KunAvatar的核心设计理念就是本地化部署,所有数据,包括您的账户信息、对话历史、记忆内容等,都完整地存储在您自己的电脑或指定的服务器上,不会被发送到任何外部的云服务商。

- 什么是MCP工具调用?它有什么用?MCP(Model Context Protocol)是一种协议,它允许KunAvatar中的AI模型与外部的独立工具或服务进行通信和互动。简单来说,它给了AI一双可以操作其他软件的“手”。例如,AI可以通过调用一个天气查询工具来获取实时天气,或者调用一个计算器工具来完成复杂的数学计算,这极大地扩展了AI的实际应用能力。

- 运行KunAvatar需要什么样的电脑配置?KunAvatar应用本身(基于Next.js)对硬件的要求不高。真正的性能瓶颈在于您通过Ollama运行的AI模型。大型的语言模型通常需要较多的内存(RAM),通常建议至少拥有16GB内存以获得流畅体验。如果模型支持,使用拥有较好GPU(特别是NVIDIA显卡)的电脑会显著提升AI的响应速度。